Was du wissen musst

- Vertragsarbeiter, die Bard von Google schulen, behaupten, die Arbeitsbedingungen seien frustrierend und die Anweisungen zu sechs Punkten seien „verwickelt“.

- Mitarbeiter haben oft die Aufgabe, eine Antwort innerhalb von drei Minuten zu prüfen.

- Auftragnehmer sind besorgt über Bards Ungenauigkeiten, allerdings heißt es in den Richtlinien, dass sie keine „strenge Faktenprüfung“ durchführen müssen.

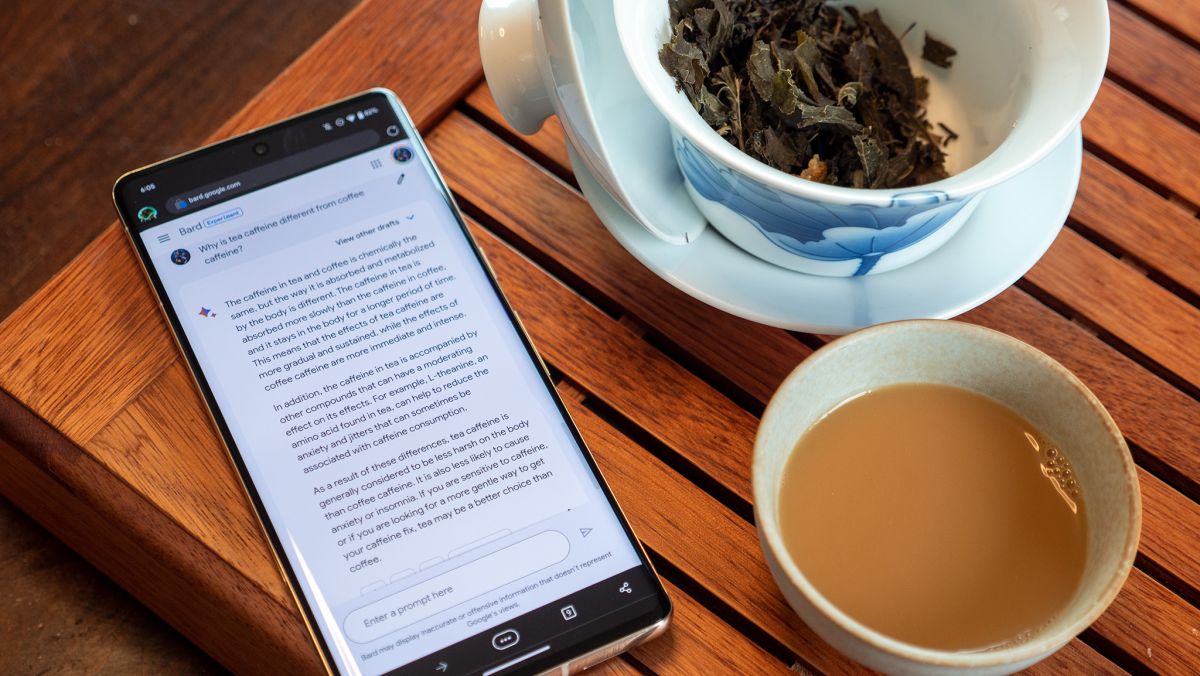

KI-Software program braucht immer noch echte Menschen, um sicherzustellen, dass sie auf dem richtigen Weg ist. Allerdings sollen solche Coach bei Google mit unerträglichen Bedingungen konfrontiert sein.

Laut Bloomberg deuten aktuelle Dokumente, die der Veröffentlichung vorliegen, darauf hin, dass menschliche Coach für Googles KI-Chatbot Bard mit „verwickelten Anweisungen“ konfrontiert wurden. Sechs der derzeitigen Auftragnehmer des Unternehmens haben sich zu den nicht gerade hervorragenden Arbeitsbedingungen geäußert. Einer sagte: „So wie es jetzt aussieht, sind die Leute verängstigt, gestresst, unterbezahlt und wissen nicht, was los ist.“

Angesichts dieser Belastung haben Mitarbeiter erklärt, dass sie oft damit beauftragt werden, eine Antwort innerhalb von drei Minuten zu prüfen. Im Kontext sind diese Vertragsarbeiter im Wesentlichen Bewerter: Personen, deren Aufgabe es ist, die Relevanz, Authentizität und Kohärenz einer Antwort zu bestimmen. Bard kann eine Anfrage auf der Grundlage einer Sechs-Punkte-Richtlinie stellen.

Diese Coach müssen außerdem sicherstellen, dass die Antworten keine beleidigenden oder schädlichen Inhalte enthalten. Angesichts dieser Tatsache besagen die Richtlinien, dass Coach „keine strenge Faktenprüfung durchführen müssen“. Das magazine zwar in Ordnung erscheinen, doch Coach haben herausgefunden, dass Googles Bard dazu neigt, die „Hauptfakten“ zu einem Thema falsch darzustellen.

Es ist ein Rätsel, dass in den zuvor genannten Richtlinien bestimmte sachliche Ungenauigkeiten, wie etwa die Angabe eines falschen Datums, als „geringfügig“ eingestuft werden.

Darüber hinaus haben Bewerter Aufgaben wie die Bestimmung der geeigneten Dosierung für jemanden erwähnt, der Bluthochdruck behandeln möchte. Aufgrund der reinen Zeitbeschränkung befürchten die Mitarbeiter, dass Bard scheinbar korrekte Antworten gibt, obwohl dies nicht der Fall ist.

In einer Stellungnahme betont Google, dass die Bewerter nur eine der verschiedenen Methoden sind, mit denen das Unternehmen Antworten auf Genauigkeit und Qualität der Antworten prüft:

„Wir unternehmen umfangreiche Anstrengungen, um unsere KI-Produkte verantwortungsvoll zu entwickeln, einschließlich strenger Exams, Schulungen und Feedbackprozesse, die wir über Jahre hinweg verfeinert haben, um die Faktizität hervorzuheben und Vorurteile zu reduzieren.“

Das Unternehmen fügt hinzu, dass es über die Genauigkeit hinaus noch andere Bereiche wie Ton und Präsentation gibt, für die einige besorgte Mitarbeiter möglicherweise geschult wurden.

Nach dem Erfolg von OpenAIs ChatGPT für die Bing-Suchmaschine von Microsoft hat Google offenbar kopfüber mit der Entwicklung eines eigenen KI-Chatbots begonnen. Die menschlichen Coach haben nicht nur angegeben, dass sie seit Januar KI-Vorbereitungsarbeiten durchgeführt haben, um es für die öffentliche Veröffentlichung vorzubereiten, sondern ein ehemaliger Google-Ingenieur behauptete auch, Bard sei mithilfe seines Konkurrenten trainiert worden, was möglicherweise zu seiner schnellen Veröffentlichung geführt habe.